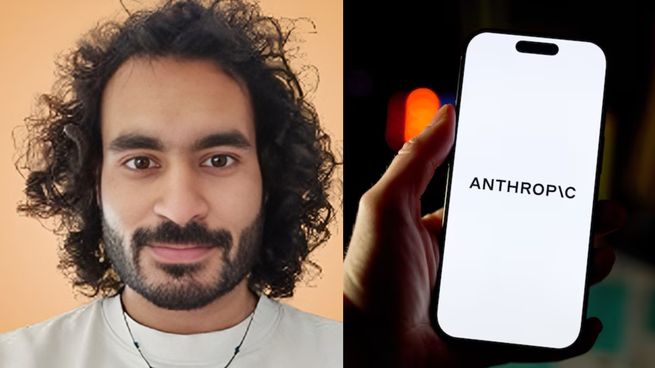

Mrinank Sharma presentó su renuncia como jefe de Salvaguardas de Anthropic y advirtió sobre los riesgos éticos que atraviesan a la industria tecnológica. El investigador difundió una carta pública en la que reflexionó sobre los límites de la inteligencia artificial y lanzó una frase que resonó en Silicon Valley: “El mundo está en peligro por la inteligencia artificial”.

Renunció el jefe de seguridad de una de las empresas más grandes de IA del mundo y dejó una fuerte advertencia por el futuro

El responsable de seguridad de una de las principales firmas de IA dejó su cargo y cuestionó la integridad del sector tecnológico.

-

Aumentan las advertencias de los CEOs por la rápida evolución de la IA y alertan: "Algo grande está pasando"

-

Alphabet vendió un bono a 100 años para financiar la expansión de la IA

Mrinank Sharma dejó su cargo como jefe de Salvaguardas de Anthropic el 9 de febrero.

Sharma ocupaba un rol clave en una de las compañías más influyentes del ecosistema actual. Anthropic, con sede en San Francisco, fue fundada en 2021 por exintegrantes de OpenAI, creadores de ChatGPT, y se consolidó como una de las firmas que promueve un desarrollo más seguro e interpretable de la IA.

La empresa construyó su identidad alrededor de una promesa: diseñar sistemas confiables, entrenados bajo principios y valores humanos predefinidos. Su chatbot, Claude, compite directamente con ChatGPT y con las soluciones desarrolladas por Google y Microsoft, posicionando a Anthropic como uno de los actores centrales en la carrera global por la inteligencia artificial.

La advertencia de Sharma en su carta pública

En la carta que publicó en X, Sharma repasó su trabajo durante dos años en áreas sensibles, como la detección de adulación en modelos de IA (cuando el sistema distorsiona respuestas para complacer al usuario) y el diseño de mecanismos de prevención frente al bioterrorismo asistido por algoritmos.

“El mundo está en peligro. Y no solo por la IA o las armas biológicas, sino por una serie de crisis interconectadas que se desarrollan en este mismo momento”, escribió. Su planteo señala un desequilibrio creciente, ya que la capacidad humana de transformar el mundo avanza a una velocidad que no siempre encuentra un desarrollo equivalente en sabiduría ni en responsabilidad colectiva.

Competencia, inversión y ética en la carrera por la inteligencia artificial

Sharma también describió tensiones internas vinculadas al ritmo acelerado con el que avanza la industria tecnológica. Señaló que la competencia por lanzar modelos cada vez más potentes y captar inversiones puede generar presiones para priorizar metas comerciales o estratégicas por encima de criterios éticos y de seguridad. En ese contexto, advirtió que sostener estándares de integridad no siempre resulta sencillo.

Su último proyecto en la compañía estuvo enfocado en analizar cómo los asistentes de inteligencia artificial pueden influir en el comportamiento y en la percepción de las personas. La investigación buscaba evaluar si el uso cotidiano de estos sistemas podría modificar la forma en que los usuarios toman decisiones, se informan o se relacionan, e incluso si podría afectar rasgos vinculados con la autonomía y el pensamiento crítico.

Tras anunciar su salida, Sharma confirmó que regresará al Reino Unido. Allí planea iniciar un período de bajo perfil, alejado de las estructuras corporativas, para dedicarse al estudio de la poesía, la escritura y la construcción comunitaria. Según explicó, su intención es combinar reflexión científica con exploración artística, en una etapa orientada a repensar el vínculo entre tecnología y humanidad.

Su renuncia reabre un debate central en el sector tecnológico. Si un directivo encargado de diseñar y supervisar mecanismos de seguridad considera que el contexto actual dificulta actuar con plena coherencia ética, la discusión sobre los límites, regulaciones y controles de la inteligencia artificial adquiere una relevancia aún mayor.

Dejá tu comentario