A medida que la inteligencia artificial se consolida como una tecnología transversal en los procesos productivos, comerciales y operativos de las empresas, también empieza a quedar más expuesta su contracara menos visible: el aumento sostenido de los riesgos de seguridad digital.

- ámbito

- Negocios

- Inteligencia Artificial

La otra cara de la inteligencia artificial: las empresas ganan eficiencia, pero enfrentan más riesgos de ciberataques

La adopción de IA en los procesos se traduce en superficies vulnerables más amplias. Mientras el delito digital se hace más sofisticado, en el mundo faltan 4,7 millones de expertos en ciberseguridad.

-

Ciberseguridad: para Microsoft, el riesgo crece pero en las empresas permanece el "a mí no me va a pasar"

-

Google dio detalles de su estrategia de ciberseguridad ante el avance de los agentes inteligencia artificial

La suplantación de identidad será uno de los ciberdelitos frecuentes de 2026, según los reportes del sector.

La adopción acelerada de soluciones basadas en IA promete eficiencia, automatización y mejoras de productividad difíciles de ignorar, pero al mismo tiempo amplía de manera significativa la superficie de ataque disponible para los ciberdelincuentes, según advierten informes coincidentes elaborados por empresas del sector.

Lejos de tratarse de un problema hipotético, distintos estudios del sector tecnológico coinciden en que esta vulnerabilidad ya es una realidad concreta. Según un relevamiento reciente, el 97% de las compañías sufrió durante el último año incidentes de seguridad relacionados con el uso de inteligencia artificial, una cifra que pone en evidencia la magnitud del desafío y anticipa un escenario todavía más complejo de cara a 2026.

Los datos surgen de distintos reportes y análisis elaborados por actores clave del ecosistema tecnológico global, entre ellos Akamai, Globant, PwC y Fortinet.

Desde perspectivas complementarias, estas firmas advierten sobre un mismo fenómeno: la IA ya no es sólo una herramienta defensiva o un habilitador de negocios, sino también un nuevo vector de riesgo que está siendo explotado de manera cada vez más sofisticada por organizaciones criminales y actores maliciosos.

El dilema estratégico de las compañías

En este nuevo contexto, las empresas se enfrentan a un dilema estratégico. Por un lado, necesitan avanzar con la adopción de IA para no perder competitividad. Por el otro, deben hacerlo sabiendo que cada nuevo modelo, agente autónomo o sistema inteligente expuesto a datos sensibles puede transformarse en una puerta de entrada para ataques difíciles de detectar con los esquemas tradicionales de ciberseguridad.

Desde Akamai, uno de los principales proveedores globales de servicios de ciberseguridad y cloud, el diagnóstico es contundente. En sus predicciones sobre seguridad e inteligencia artificial para 2026, los especialistas de la compañía advierten que los grandes modelos de lenguaje dejarán de ser únicamente herramientas de productividad o soporte defensivo para convertirse también en el origen de nuevas amenazas.

“Los atacantes ya están aprendiendo a explotar vulnerabilidades propias de los modelos de IA”, asegura, como la inyección de instrucciones maliciosas, la contaminación de los datos de entrenamiento o la manipulación de fuentes externas conectadas a estos sistemas.

A diferencia de los ataques clásicos, estas técnicas no requieren comprometer el software tradicional, lo que dificulta su detección y respuesta mediante los mecanismos de seguridad actuales.

Para Jairo Parra, experto en ciberseguridad de Akamai Latinoamérica, el foco de riesgo se traslada ahora al ciclo de vida completo de la inteligencia artificial. La integridad, trazabilidad y seguridad de los modelos, desde el entrenamiento hasta su despliegue y actualización, se convierte en una prioridad crítica.

Si los datos de entrenamiento son alterados o si un modelo es inducido a comportarse de manera inesperada, el impacto puede ser profundo y silencioso, afectando decisiones automatizadas, procesos de negocio y, en última instancia, a los consumidores finales, alerta.

A esta amenaza estructural se suma el uso creciente de la IA como herramienta directa del delito. Bobby Blumofe, vicepresidente ejecutivo y director de tecnología de Akamai, anticipa que en 2026 los ciberdelincuentes comenzarán a utilizar de forma sistemática modelos de lenguaje y plataformas de automatización avanzada para lanzar estafas sofisticadas contra empresas.

El ciberdelito se traslada de los individuos a las corporaciones

Hasta ahora, la mayoría de los fraudes impulsados por IA tuvieron como objetivo a usuarios individuales, pero el foco empieza a desplazarse hacia organizaciones de mayor escala, donde los pagos potenciales son mucho más elevados y los procesos automatizados pueden ser explotados con mayor impacto.

Uno de los vectores más sensibles de este nuevo escenario es la manipulación de identidades y la erosión de la confianza digital.

En ese sentido, Akamai prevé que los deepfakes de video en tiempo real alcanzarán un nivel de realismo suficiente como para engañar incluso a profesionales experimentados, trasladando las estafas desde redes sociales o contenidos grabados hacia interacciones en vivo, como reuniones virtuales, entrevistas o llamadas corporativas.

En un entorno donde “ver para creer” deja de ser una regla válida, las empresas deberán replantear sus mecanismos de verificación, autenticación y validación de identidad.

El impacto de estas amenazas no se limita a las organizaciones. Los consumidores también quedan expuestos a nuevas formas de fraude, robo de identidad y manipulación.

Los ataques dirigidos a sistemas de pago sin contacto, como los basados en tecnología NFC, son un ejemplo claro de esta tendencia.

Según las proyecciones de Akamai, los ciberdelincuentes están abandonando las campañas masivas para enfocarse en ataques localizados, adaptados a países, sistemas bancarios y marcos regulatorios específicos, lo que incrementa su tasa de éxito y dificulta la detección temprana.

Para los usuarios finales, esto puede traducirse en pérdidas económicas, filtración de datos personales y una creciente desconfianza hacia los sistemas digitales.

El 97% de las empresas ya recibió ciberataques con IA

El diagnóstico de Globant coincide en que la madurez de la IA empresarial trae consigo riesgos proporcionales a su nivel de integración. En su informe “Tech Trends 2026”, la compañía señala que las organizaciones están dejando atrás la fase experimental para construir inteligencia operativa, escalable y orientada al retorno de la inversión. Sin embargo, este salto cualitativo implica también una exposición mayor.

De acuerdo con el reporte, el 97% de las compañías ya sufrió incidentes de seguridad relacionados con IA debido a controles de acceso deficientes, incluso aquellas que utilizan estas tecnologías como parte de su estrategia defensiva.

Globant advierte que los atacantes están aprovechando la IA para escalar tareas de reconocimiento, automatizar la explotación de vulnerabilidades y generar deepfakes cada vez más creíbles.

Frente a este escenario, las empresas migran hacia modelos de defensa predictiva impulsados por IA, que incluyen verificación de identidad avanzada y modelado proactivo de amenazas.

Sin embargo, el informe subraya que la tecnología por sí sola no es suficiente. La ausencia de marcos de gobernanza claros y de una estrategia integral de seguridad puede convertir a la IA en un factor de riesgo adicional en lugar de una solución.

La IA autónoma como recurso defensivo ante los delitos con IA

La perspectiva de PwC aporta otro matiz relevante al debate: la creciente adopción de IA autónoma en ciberseguridad. Según su publicación global “The Rise of Autonomous AI in Cybersecurity”, más de la mitad de los líderes de seguridad ya están explorando o implementando este tipo de soluciones, y un 27% planea hacerlo en los próximos dos años.

La expectativa corporativa es contar con sistemas capaces de detectar, decidir y responder a incidentes sin intervención humana directa, reduciendo drásticamente los tiempos de reacción frente a ataques cada vez más veloces y complejos.

No obstante, PwC advierte que esta autonomía también implica riesgos si no está acompañada de un gobierno corporativo sólido, marcos éticos claros y supervisión constante.

Diego Taich, socio de PwC Argentina y líder de la práctica de Cybersecurity, Technology & Forensics, señala que en América Latina la IA autónoma se presenta como una respuesta tanto a la sofisticación de las amenazas como a la escasez de talento especializado.

El desafío consiste en encontrar el equilibrio adecuado entre automatización y control humano, evitando que decisiones críticas queden completamente fuera del alcance de la supervisión.

Sin embargo, ese objetivo se enfrenta con el déficit de talento. Este es, precisamente, uno de los factores que más agravan la vulnerabilidad de las empresas frente a los riesgos asociados a la IA.

La escasez de talento también afecta la ciberseguridad

Un reporte de Fortinet sobre la brecha de habilidades en ciberseguridad revela que América Latina enfrenta un déficit de 329.000 profesionales especializados, en un contexto donde más del 80% de las organizaciones de la región ya experimentaron al menos un ciberataque en el último año.

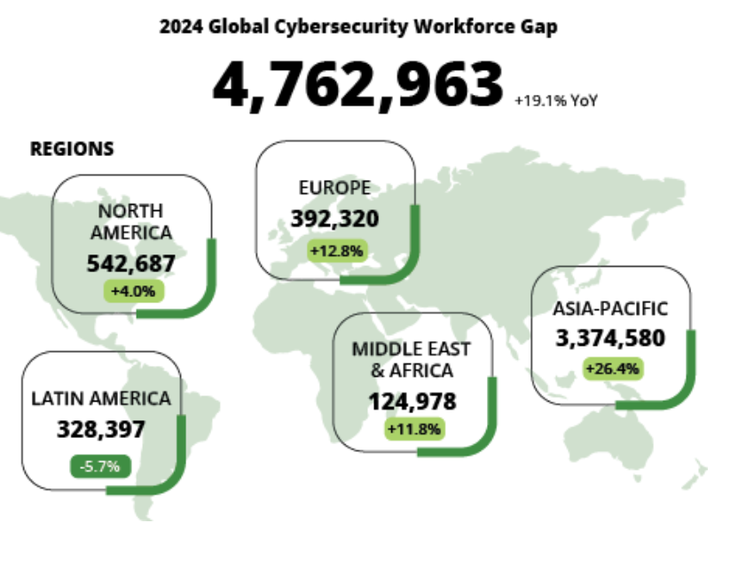

A nivel global, la escasez supera los 4,7 millones de especialistas, una cifra que expone la dificultad de acompañar el ritmo de adopción tecnológica con capacidades humanas suficientes.

Según Fortinet, el 86% de las organizaciones latinoamericanas sufrió al menos una intrusión en 2024, y una de cada cinco enfrentó cinco o más incidentes en un solo año.

Más del 60% de los responsables de IT identifica la falta de capacitación como una de las principales causas de estas vulneraciones, mientras que el 35% reporta pérdidas superiores al millón de dólares por incidentes de seguridad.

En este escenario, la IA aparece como un alivio potencial, pero también como un desafío adicional: el 98% de las organizaciones de la región ya utiliza o planea implementar IA en sus estrategias de seguridad, aunque más de la mitad reconoce no contar con la experiencia necesaria para hacerlo de manera efectiva.

De cara a 2026, el consenso entre los informes de Akamai, Globant, PwC y Fortinet es contundente: la inteligencia artificial seguirá expandiéndose y profundizando su impacto en todos los sectores, pero lo hará en un entorno de amenazas crecientes.

Concluyen que la clave para evitar el delito no estará en frenar la adopción de IA, sino en integrar la seguridad como un componente central desde el diseño, combinando tecnología, talento, gobernanza y conciencia organizacional.

Dejá tu comentario