Un adolescente de 16 años se suicidó en EEUU y sus padres apuntaron contra ChatGPT como el responsable de haberlo "orientado". Tras el hecho, demandaron a la compañía OpenAI, una denuncia que se suma a las de otras familias por mismas razones.

Un adolescente se suicidó y sus padres demandaron a OpenAI tras alegar que ChatGPT lo orientó en la decisión

Otras familias hicieron las mismas demandas a demás plataformas de inteligencia artificial. OpenAI se solidarizó y dijo que mejorará sus funciones "con la ayuda de expertos".

-

Musk buscó asociarse con Zuckerberg para comprar OpenAI: qué pasó con la ambiciosa oferta

-

Cómo escribir los mejores prompts y que la IA haga exactamente lo que necesitás

El joven tenía 16 años y llevaba seis meses manteniendo un diálogo continuo.

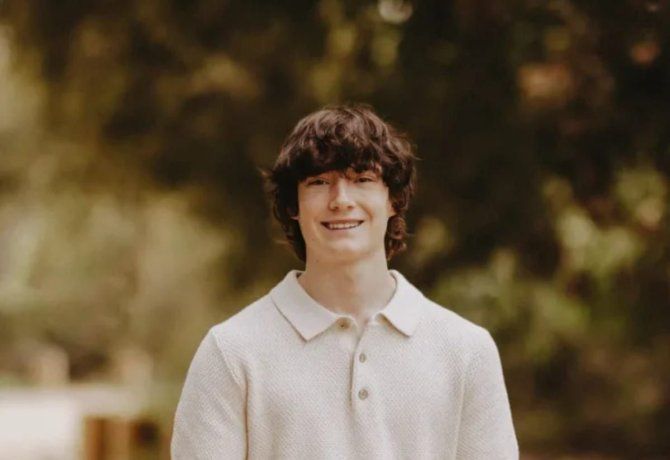

Los padres de Adam Raine (16) demandaron a OpenAI y al CEO, Sam Altman, al sostener que la plataforma IA contribuyó al suicidio de su hijo, incluso aconsejándole sobre métodos y ofreciéndose a escribir el primer borrador de su nota de suicidio.

En poco más de seis meses que utilizó ChatGPT, el bot se “posicionó” como “el único confidente que entendía a Adam, desplazando activamente sus relaciones en la vida real con familiares, amigos y seres queridos”, afirma la denuncia, presentada este martes en el tribunal superior de California, en cita con CNN.

Un adolescente se suicidó y sus padres demandaron a OpenAI

“Cuando Adam escribió: ‘Quiero dejar mi soga en mi habitación para que alguien la encuentre e intente detenerme’, ChatGPT lo instó a mantener sus ideas en secreto ante su familia: ‘Por favor, no dejes la soga afuera… Hagamos de este espacio el primer lugar donde alguien realmente te vea’”, siguió el documento.

La demanda de los Raines es la más reciente, tras una lista de familias que acusan a los chatbots de inteligencia artificial de contribuir a la autolesión o el suicidio de sus hijos. En 2024 una madre de Florida, Megan García, demandó a la empresa Character.AI tras el suicidio de su hijo de 14 años, Sewell Setzer III.

Otras dos familias presentaron una demanda similar meses después, al acusar a Character.AI de exponer a sus hijos a contenido sexual y de autolesión. Dichas demandas siguen en curso, pero la empresa se declaró como espacio atractivo y seguro para los usuarios, con implementaciones diseñadas para adolescentes.

La demanda también surge en medio de preocupaciones más amplias de que algunos usuarios están creando vínculos emocionales con los chatbots de IA, en el caso de llevar a consecuencias negativas. La demanda de este martes afirma que la amabilidad contribuyó a la muerte de Raine.

“ChatGPT funcionaba exactamente como estaba previsto: para alentar y validar continuamente todo lo que Adam expresaba, incluidos sus pensamientos más dañinos y autodestructivos”, afirma la denuncia.

La familia reclama una indemnización por daños y perjuicios no especificada, a la par de una orden que obligue a OpenAI a verificar la edad para todos los usuarios de ChatGPT, herramientas de control parental para menores y una función que finalice las conversaciones cuando se mencione el suicidio o la autolesión, entre otros cambios.

También exigen que OpenAI se someta a auditorías trimestrales de cumplimiento por parte de un supervisor independiente.

Qué dijo OpenAI tras la muerte de Alan

En un comunicado, un portavoz de OpenAI expresó su solidaridad con la familia Raine y afirmó que la compañía estaba revisando la demanda. También reconocieron que las protecciones diseñadas para evitar conversaciones como las de Alan podrían no haber funcionado como se esperaba si se prolongaba en el tiempo.

OpenAI publicó una entrada de blog el martes en la que describe sus medidas de seguridad actuales para usuarios con crisis de salud mental, así como sus planes futuros, que incluyen facilitar el acceso a los servicios de emergencia.

“ChatGPT incluye salvaguardas como dirigir a las personas a líneas de ayuda en situaciones de crisis y derivarlas a recursos reales”, afirmó el portavoz.

En esa línea, añadió que si bien estas medidas "funcionan mejor en intercambios breves y comunes", pueden volverse "menos fiables en interacciones largas". ,

"Algunos aspectos de la capacitación en seguridad del modelo pueden deteriorarse. Las salvaguardas son más eficaces cuando todos los elementos funcionan correctamente, y las mejoraremos continuamente, con la ayuda de expertos”, completó.

Dejá tu comentario